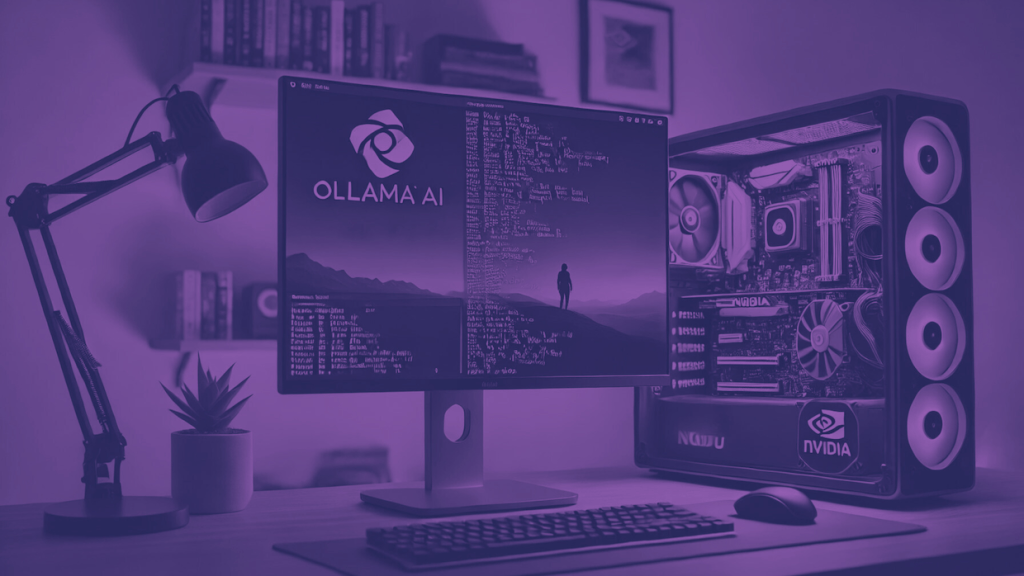

Ubuntu’da Ollama AI’yi Kurun, Kendi Makinanızda Farklı LLM’leri Deneyin

Günümüzde, büyük dil modelleri (LLM’ler) yapay zeka uygulamalarının merkezinde yer alıyor ve birçok kullanıcı, bu güçlü araçları kendi bilgisayarlarında çalıştırmak istiyor.

Ubuntu Linux kullanıcıları için, Ollama AI ile LLM’leri yerel olarak çalıştırmak artık çok daha erişilebilir ve basit.

The New Stack’te yayınlanan bu kılavuz, NVIDIA GPU’lu modern bir makine üzerinde Ollama AI kurulumunu ve LLM’lerin nasıl kullanılacağını adım adım açıklayarak, gizlilik, özelleştirme ve maliyet kontrolü avantajlarını sunuyor.

Adımlar:

Sistem Gereksinimlerini Kontrol Edin Optimum performans için modern bir CPU ve NVIDIA GPU’ya sahip bir makineye ihtiyacınız olacak.

Gerekli NVIDIA sürücülerinin kurulu olduğunu doğrulamak için nvidia-smi -a komutunu kullanın veya sudo ubuntu-drivers install ile sürücüleri yükleyin.

Ollama’yı Yükleyin

Ollama’yı yüklemek için aşağıdaki komutu çalıştırın:

$ curl -fsSL https://ollama.com/install.sh | sh

Bu, Ollama’yı ve bağımlılıklarını yükleyecektir.

Bir Model İndirin Ollama kütüphane sitesini ziyaret edin ve kullanmak istediğiniz bir LLM’yi seçin, örneğin, Llama3. Ardından şu komutu çalıştırın:

$ ollama run llama3

Bu, Llama3 modelini indirecektir.

LLM’yi Kullanın Model indirme tamamlandıktan sonra, “Send a message (/? for help)" şeklinde bir istem göreceksiniz. Sorgunuzu yazın ve Ollama, seçtiğiniz LLM’yi kullanarak bir yanıt üretecektir.

Ollama’dan Çıkış Yapın Ollama’dan çıkmak için Ctrl+D tuşlarına basın.

Farklı Bir LLM Çalıştırın Farklı bir LLM kullanmak için şu komutu çalıştırın:

$ ollama run LLM_NAME

LLM_NAME yerine Ollama kütüphanesindeki istediğiniz modelin adını yazın.

Ollama, Llama3, Qwen2, Phi3, Aya, Mistral ve Gemma gibi LLM’leri Ubuntu makinenizde yerel olarak çalıştırmanıza olanak tanır, bu da halka açık AI hizmetlerine kıyasla gizlilik, özelleştirme ve maliyet kontrolü sağlar.

Kurulum süreci basittir ve başkalarına kendi sorgularını çalıştırmaları için makineye erişim izni verebilirsiniz